Gemma

Prezentare generală

Google DeepMind lansează Gemma, o serie de modele de limbaj deschise inspirate de aceeași cercetare și tehnologie folosită pentru a crea Gemini. Lansarea modelului Gemma include:

- Modelul 2B: Antrenat pe 2T tokeni

- Modelul 7B: Antrenat pe 6T tokeni

- Checkpoint-uri de bază și fine-tunate pentru instrucțiuni

- Lungimea contextului: 8192 tokeni

- Performanța: În general depășește Llama 2 7B și Mistral 7B pe mai multe benchmark-uri

Arhitectura

Arhitectura modelului Gemma este bazată pe transformer decoder cu îmbunătățiri care includ:

- Atenția multi-query (folosită de modelul 2B)

- Atenția multi-head (folosită de modelul 7B)

- Încorporările RoPE

- Activațiile GeGLU

- Locația normalizatorului

Datele de antrenament

- Gemma 2B: Antrenat pe 2T tokeni

- Gemma 7B: Antrenat pe 6T tokeni

- Conținutul: Documente web, matematică și cod

- Limba: Doar engleză (fără antrenament multilingv explicit)

- Multimodal: Fără capacități multimodale explicite

Specificațiile tehnice

- Dimensiunea vocabularului: 256K tokeni

- Tokenizarea: Subset al tokenizer-ului SentencePiece din Gemini

- Caracteristici: Păstrează spațiile albe, împarte cifrele, codificări la nivel de byte pentru tokeni necunoscuți

Fine-tuning-ul pentru instrucțiuni

Modelele fine-tunate pentru instrucțiuni sunt fine-tunate folosind:

- Fine-tuning supervizat pe un amestec de perechi prompt-răspuns sintetice doar-text și generate de oameni

- Învățarea prin întărire din feedback-ul uman (RLHF) cu:

- Model de recompensă antrenat pe date de preferințe etichetate

- Politică bazată pe un set de prompturi de înaltă calitate

Notă: Toate seturile de date folosite sunt doar în engleză.

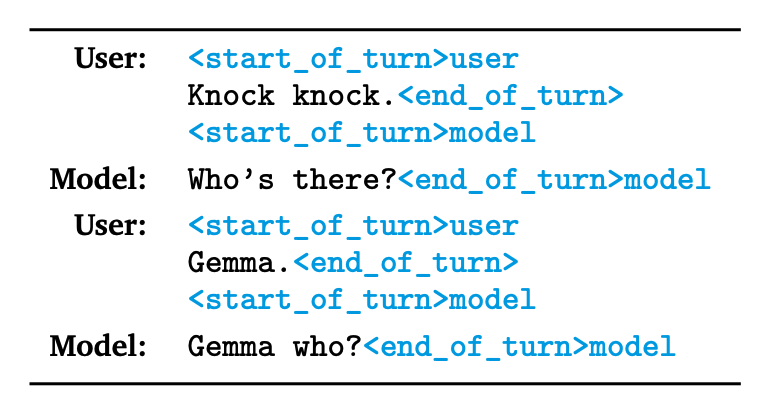

Tokenii de control

Modelele fine-tunate pentru instrucțiuni folosesc tokeni de formatare de control specifici pentru a indica rolurile și turele într-o conversație:

Rezultate

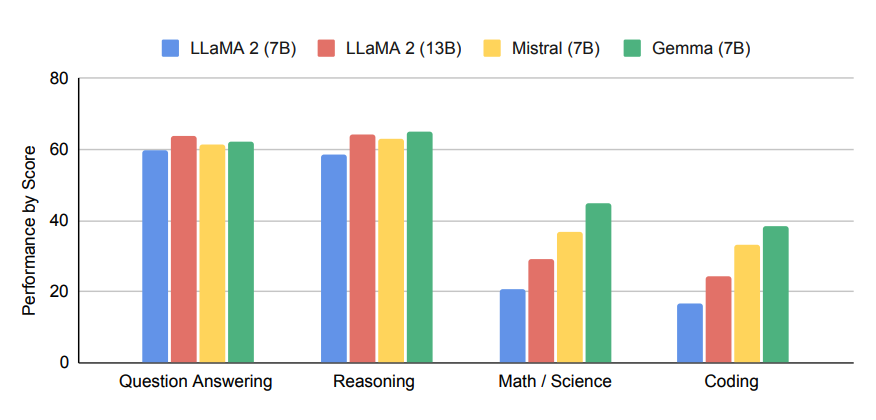

Capacitățile de performanță

Așa cum se arată în figura de mai jos, modelul Gemma 7B demonstrează performanță puternică pe sarcini de matematică, știință și cod. Scorurile corespund scorurilor medii pe evaluările benchmark-urilor academice grupate pe capacitate.

Compararea pe benchmark-uri

Gemma 7B depășește Llama 2 7B și Mistral 7B pe diverse benchmark-uri academice cu performanță notabilă pe:

- HumanEval

- GSM8K

- MATH

- AGIEval

Performanța îmbunătățită pe:

- Raționament

- Dialog

- Matematică

- Cod

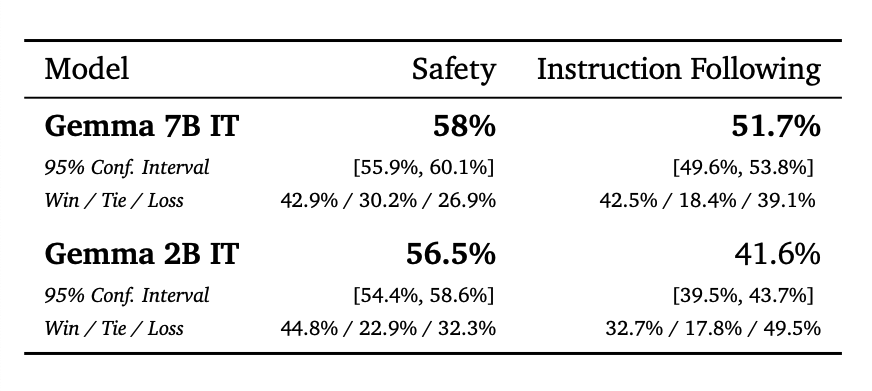

Evaluarea siguranței

Modelele Gemma 7B fine-tunate pentru instrucțiuni depășesc, de asemenea, modelul Mistral-7B v0.2 Instruct pe siguranță și urmărirea instrucțiunilor așa cum sunt evaluate de oameni.

Gemma este evaluată pe mai multe benchmark-uri academice de siguranță și comparată cu Mistral. Raportul tehnic menționează folosirea:

- Tehnicilor de debiasing

- Red-teaming pentru a atenua potențial riscurile comune asociate cu LLM-urile

Resurse: Puteți găsi mai multe informații despre cum să dezvoltați responsabil cu Gemma în model card și Responsible Generative AI toolkit.

Formatul promptului

Modelele de bază

Modelele Gemma de bază nu folosesc niciun format de prompt specific dar pot fi promptate să execute sarcini prin promptarea zero-shot/few-shot.

Formatul modelului Instruct

Modelul Gemma Instruct folosește următorul format:

<start_of_turn>user

Generează o funcție Python care înmulțește două numere <end_of_turn>

<start_of_turn>modelReferința tokenilor de control

| Context | Token relevant |

|---|---|

| Tura utilizatorului | user |

| Tura modelului | model |

| Începutul turei de conversație | <start_of_turn> |

| Sfârșitul turei de conversație | <end_of_turn> |

Exemplul multi-turn

Puteți folosi, de asemenea, tokenii de control speciali în contextul unui prompt multi-turn al utilizatorului:

<start_of_turn>user

Care este un loc bun pentru călătorie în SUA?<end_of_turn>

<start_of_turn>model

California.<end_of_turn>

<start_of_turn>user

Ce pot face în California?<end_of_turn>

<start_of_turn>modelCum să promptezi Gemma 7B

Promptarea eficientă a Gemma 7B necesită să poți folosi corect template-ul de prompt. Iată exemple care demonstrează utilizarea eficientă a template-ului de prompt Gemma 7B Instruct pentru diverse sarcini.

Promptarea zero-shot

Ca cu orice model, puteți utiliza capacitățile zero-shot ale Gemma:

<start_of_turn>user

Explică de ce cerul este albastru<end_of_turn>

<start_of_turn>modelPromptarea zero-shot cu prompt de sistem

Adăugarea unui rol de sistem sau prompt de sistem ajută la direcționarea mai bună a LLM-urilor. Deși nu există un rol de sistem explicit în Gemma, puteți adăuga instrucțiuni suplimentare:

<start_of_turn>user

Răspunde la următoarea întrebare într-un mod concis și informativ:

Explică de ce cerul este albastru<end_of_turn>

<start_of_turn>modelNotă: Am adăugat "Răspunde la următoarea întrebare într-un mod concis și informativ:" ca instrucțiune suplimentară pentru a direcționa mai bine modelul.

Jocul de roluri

Putem testa Gemma pentru capacitățile de joc de roluri, utile pentru personalizarea răspunsurilor modelului și construirea agenților LLM specifici domeniului.

Prompt:

<start_of_turn>user

Ești un profesor de clasa a 2-a de ajutor. Ajută un elev de clasa a 2-a să răspundă la întrebări într-un mod scurt și clar.

Explică de ce cerul este albastru<end_of_turn>

<start_of_turn>modelRăspunsul modelului:

Desigur, iată o explicație pentru de ce cerul este albastru:

Cerul pare albastru din cauza unui fenomen numit Împrăștierea Rayleigh.

Iată știința din spatele acestuia:

- Lumina soarelui este formată din culori diferite de lumină, precum roșu, verde, albastru și violet.

- Când lumina soarelui lovește atmosfera Pământului, culorile diferite de lumină se împrăștie în direcții diferite.

- Lumina albastră se împrăștie mai ușor decât alte culori deoarece are lungimi de undă mai scurte.

- Lumina albastră împrăștiată călătorește în toate direcțiile, inclusiv spre ochii tăi.

- De aceea vedem cerul ca fiind albastru.

Este important să rețineți că această explicație este simplificată și nu ține cont de toate detaliile științifice. Cu toate acestea, vă oferă o înțelegere bună a științei de bază din spatele motivului pentru care cerul pare albastru.

Notă: Nu am verificat răspunsul pentru acuratețe sau potrivirea pentru un elev de clasa a 2-a. Puteți compara aceasta cu răspunsul promptului chain-of-thought care urmează.

Raționamentul

Puteți elicita capacitățile de raționament ale Gemma folosind promptarea zero-shot chain-of-thought:

Prompt:

<start_of_turn>user

Gândește-te și scrie raționamentul tău pas cu pas înainte de a răspunde.

Explică de ce cerul este albastru.<end_of_turn>

<start_of_turn>modelRăspunsul modelului (trunchiat pentru concizie):

Pasul 1: Împrăștierea luminii Cerul pare albastru din cauza fenomenului de împrăștiere a luminii. Când lumina soarelui lovește atmosfera Pământului, aceasta interacționează cu particulele de aer, în principal moleculele de azot și oxigen.

Pasul 2: Împrăștierea Rayleigh Împrăștierea Rayleigh este mecanismul specific de împrăștiere care are loc când lumina interacționează cu particule mult mai mici decât lungimea de undă a luminii. În acest proces, lungimile de undă mai scurte (lumina albastră) sunt împrăștiate mai eficient decât lungimile de undă mai lungi (lumina roșie).

Pasul 3: Lumina albastră împrăștiată călătorește în toate direcțiile ...

Concluzia Cerul pare albastru din cauza împrăștierii luminii, specific împrăștierea Rayleigh. Lungimile de undă mai scurte de lumină sunt împrăștiate mai eficient, și această lumină împrăștiată călătorește în toate direcțiile, cu lumina împrăștiată care călătorește opus razelor soarelui fiind cea mai vizibilă ochilor noștri.

Caracteristici cheie:

- Gemma poate produce format markdown automat

- Am editat formatul textului pentru demonstrație și simplitate

- Conținutul este exact ceea ce a răspuns modelul

- Nu am evaluat acuratețea sau halucinația potențială

Resurse și integrații

Iată mai multe resurse și integrații care au făcut parte din lansarea Gemma:

- Colab și notebook-uri Kaggle

- Modele Hugging Face

- MaxText

- NVIDIA NeMo

- TensorRT-LLM

- NVIDIA AI Playground (Gemma 7B disponibil)

Utilizarea comercială

Conform lansării oficiale de pe blog, Termenii de utilizare permit utilizarea și distribuția comercială responsabilă pentru toate organizațiile, indiferent de dimensiune.

Învățăminte cheie

- Open Source: Modele de limbaj complet deschise bazate pe cercetarea Gemini

- Performanță puternică: Depășește modelele comparabile pe benchmark-urile academice

- Focus pe siguranță: Evaluarea comprehensivă a siguranței și tehnicile de debiasing

- Promptarea flexibilă: Suport pentru zero-shot, few-shot și joc de roluri

- Capacitățile de raționament: Promptarea chain-of-thought pentru raționament complex

- Gata pentru comerț: Permite utilizarea comercială responsabilă

- Multiple integrații: Disponibil pe platformele AI majore

Referințe

- Gemma: Introducerea unor modele deschise noi de top

- Gemma: Modele deschise bazate pe cercetarea și tehnologia Gemini

- Responsible Generative AI Toolkit

- Fast Transformer Decoding: One Write-Head is All You Need

- Roformer: Enhanced transformer with rotary position embedding

- GLU variants improve transformer

- Root mean square layer normalization