Promptarea cu stimul direcțional

Prezentare generală

Li et al., (2023) propun o nouă tehnică de promptare pentru a ghida mai bine LLM-ul în generarea rezumatului dorit.

Un model de limbaj de politică ajustabil este antrenat pentru a genera stimulul/indiciul. Se vede o utilizare mai mare a RL pentru a optimiza LLM-urile.

Cum funcționează

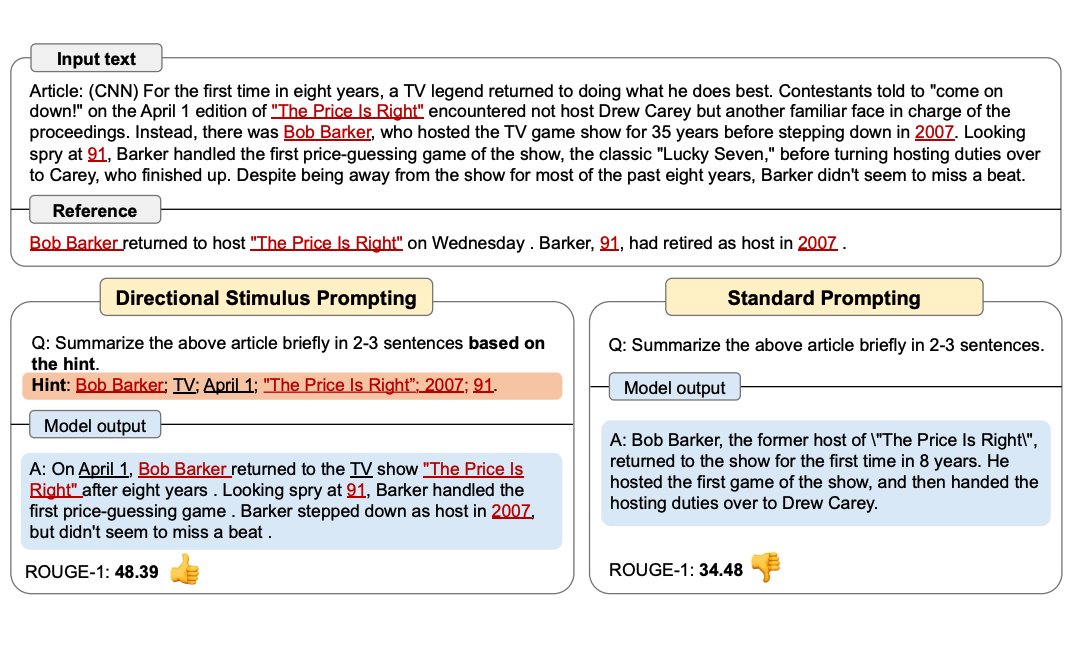

Figura de mai jos arată cum se compară Promptarea cu stimul direcțional cu promptarea standard. Modelul de limbaj de politică poate fi mic și optimizat pentru a genera indiciile care ghidează un LLM înghețat black-box.

Sursa imaginii: Li et al., (2023)

Componente cheie

- Modelul de limbaj de politică: Un model de limbaj mic, antrenabil care generează indicii direcționale

- LLM-ul înghețat: Modelul principal care primește indicii pentru a ghida generarea

- Optimizarea RL: Folosește învățarea prin întărire pentru a optimiza modelul de limbaj de politică

- Generarea de indicii: Creează stimuli specifice pentru a ghida sarcina țintă

Avantaje

- Generarea controlată: Furnizează ghidare specifică pentru ieșirile dorite

- Antrenamentul eficient: Doar modelul mic de limbaj de politică trebuie să fie antrenat

- Indicii flexibile: Poate genera diverse tipuri de stimuli direcționale

- Compatibilitatea black-box: Funcționează cu orice LLM înghețat

Aplicații

- Rezumarea textului: Ghidarea generării de rezumate cu zone de focus specifice

- Generarea de conținut: Direcționarea scrierii creative sau crearea de conținut

- Ghidarea specifică sarcinilor: Furnizarea de indicii pentru sarcini specializate

- Controlul calității: Asigurarea că ieșirile îndeplinesc criterii specifice

Starea actuală

Exemplul complet vine în curând!

Subiecte conexe

- Promptarea Chain-of-Thought - Înțelegerea tehnicilor de raționament

- Promptarea cu câteva exemple - Învățarea din exemple

- Ghidul de inginerie a prompturilor - Tehnici generale de inginerie a prompturilor

Referințe

- Li et al., (2023) - Directional Stimulus Prompting