Grok-1

Prezentare generală

Grok-1 este un model de limbaj mare (LLM) mixture-of-experts (MoE) cu 314B de parametri care include lansarea deschisă a greutăților modelului de bază și arhitectura rețelei.

Detaliile modelului

Arhitectura

- Tip: Model de limbaj mare mixture-of-experts (MoE)

- Parametri: 314B parametri totali

- Activarea: 25% din greutăți sunt activate pentru un token dat la timpul inferenței

- Antrenamentul: Dezvoltat de xAI

Informațiile de antrenament

- Data de cutoff pentru pre-antrenament: Octombrie 2023

- Status: Checkpoint-ul modelului de bază brut din faza de pre-antrenament

- Fine-tuning: Nu este fine-tunat pentru aplicații specifice precum agenții conversaționali

Licențierea

Modelul a fost lansat sub licența Apache 2.0.

Rezultate și capacități

Performanța pe benchmark-uri

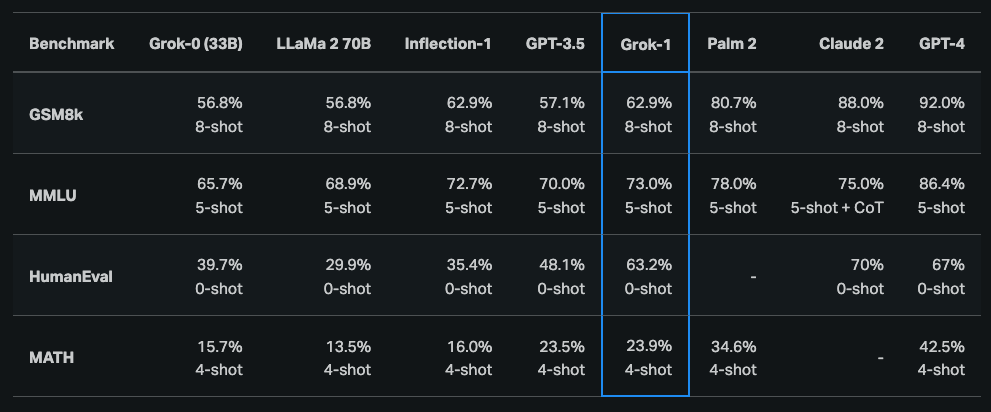

Conform anunțului inițial, Grok-1 a demonstrat capacități puternice pe sarcini de raționament și codare:

- Sarcina de codare HumanEval: 63.2%

- MMLU: 73%

Compararea modelelor

Grok-1 în general depășește:

- ChatGPT-3.5

- Inflection-1

Dar încă rămâne în urmă modelelor îmbunătățite precum GPT-4.

Rezultatele pe benchmark-uri

Performanța academică

Grok-1 a fost, de asemenea, raportat să obțină un C (59%) comparat cu un B (68%) de la GPT-4 la finalele naționale de liceu din Ungaria la matematică.

Accesul și utilizarea

Repository-ul modelului

Verificați modelul aici: https://github.com/xai-org/grok-1

Cerințele hardware

Din cauza dimensiunii Grok-1 (314B parametri), xAI recomandă o mașină multi-GPU pentru a testa modelul.

Învățăminte cheie

- Scala masivă: Arhitectura MoE de 314B parametri

- Open Source: Licențiat Apache 2.0 cu greutăți și arhitectură deschise

- Performanță puternică: Depășește ChatGPT-3.5 și Inflection-1

- Rezultate competitive: 63.2% pe HumanEval, 73% pe MMLU

- Capacitatea academică: Competă cu GPT-4 pe sarcini matematice

- Intensiv în resurse: Necesită setup multi-GPU pentru testare