Promptarea Chain-of-Thought

Prezentare generală

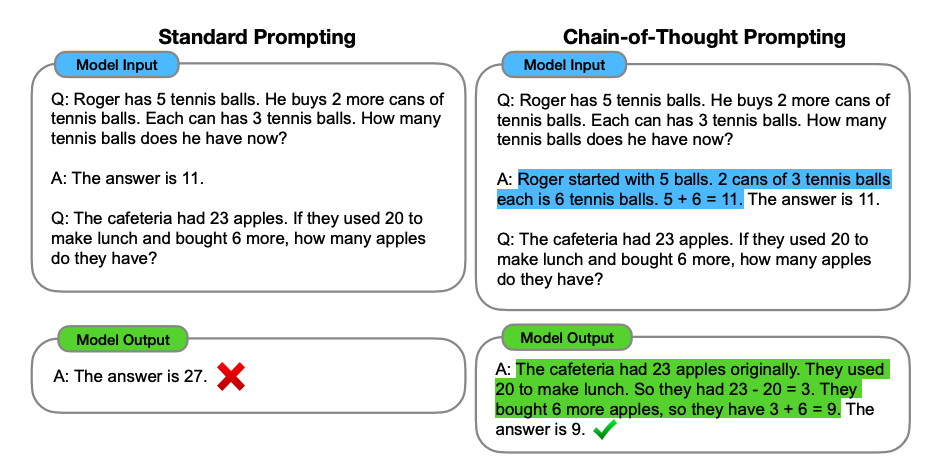

Introdusă în Wei et al. (2022), promptarea chain-of-thought (CoT) permite capacități de raționament complexe prin pași de raționament intermediari. Poți să o combini cu promptarea cu câteva exemple pentru a obține rezultate mai bune la sarcini mai complexe care necesită raționament înainte de răspuns.

Sursa imaginii: Wei et al. (2022)

Exemplu de bază

Prompt:

Numerele impare din acest grup se adună la un număr par: 4, 8, 9, 15, 12, 2, 1.

A: Adunând toate numerele impare (9, 15, 1) dă 25. Răspunsul este Fals.

Numerele impare din acest grup se adună la un număr par: 17, 10, 19, 4, 8, 12, 24.

A: Adunând toate numerele impare (17, 19) dă 36. Răspunsul este Adevărat.

Numerele impare din acest grup se adună la un număr par: 16, 11, 14, 4, 8, 13, 24.

A: Adunând toate numerele impare (11, 13) dă 24. Răspunsul este Adevărat.

Numerele impare din acest grup se adună la un număr par: 17, 9, 10, 12, 13, 4, 2.

A: Adunând toate numerele impare (17, 9, 13) dă 39. Răspunsul este Fals.

Numerele impare din acest grup se adună la un număr par: 15, 32, 5, 13, 82, 7, 1.

A:Ieșire:

Adunând toate numerele impare (15, 5, 13, 7, 1) dă 41. Răspunsul este Fals.Wow! Putem vedea un rezultat perfect când am furnizat pasul de raționament. De fapt, putem rezolva această sarcină prin furnizarea chiar mai puținelor exemple, adică doar un exemplu pare să fie suficient:

Prompt:

Numerele impare din acest grup se adună la un număr par: 4, 8, 9, 15, 12, 2, 1.

A: Adunând toate numerele impare (9, 15, 1) dă 25. Răspunsul este Fals.

Numerele impare din acest grup se adună la un număr par: 15, 32, 5, 13, 82, 7, 1.

A:Ieșire:

Adunând toate numerele impare (15, 5, 13, 7, 1) dă 41. Răspunsul este Fals.Ține minte că autorii susțin că aceasta este o capacitate emergentă care apare cu modele de limbaj suficient de mari.

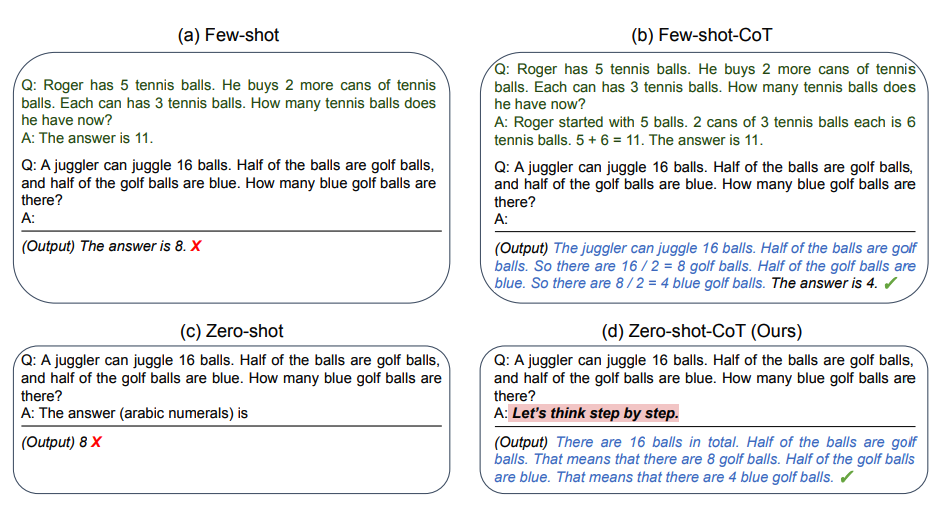

Promptarea Zero-shot COT

O idee recentă care a apărut mai recent este ideea de zero-shot CoT (Kojima et al. 2022) care implică în esență adăugarea "Să gândim pas cu pas" la promptul original. Să încercăm o problemă simplă și să vedem cum performează modelul:

Prompt:

Am mers la piață și am cumpărat 10 mere. Am dat 2 mere vecinului și 2 reparatorului. Apoi am mers și am cumpărat încă 5 mere și am mâncat 1. Cu câte mere am rămas?Ieșire:

11 mereRăspunsul este incorect! Acum să încercăm cu promptul special.

Prompt:

Am mers la piață și am cumpărat 10 mere. Am dat 2 mere vecinului și 2 reparatorului. Apoi am mers și am cumpărat încă 5 mere și am mâncat 1. Cu câte mere am rămas?

Să gândim pas cu pas.Ieșire:

Mai întâi, ai început cu 10 mere.

Ai dat 2 mere vecinului și 2 reparatorului, deci ai rămas cu 6 mere.

Apoi ai cumpărat încă 5 mere, deci acum ai avea 11 mere.

În final, ai mâncat 1 măr, deci ai rămâne cu 10 mere.Este impresionant că acest prompt simplu este eficient la această sarcină. Aceasta este deosebit de utilă unde nu ai prea multe exemple de folosit în prompt.

Chain-of-Thought automat (Auto-CoT)

Când aplici promptarea chain-of-thought cu demonstrații, procesul implică crearea manuală de exemple eficiente și diverse. Acest efort manual ar putea duce la soluții suboptimale. Zhang et al. (2022) propun o abordare pentru a elimina eforturile manuale prin utilizarea LLM-urilor cu promptul "Să gândim pas cu pas" pentru a genera lanțuri de raționament pentru demonstrații unul câte unul. Acest proces automat poate încă să se termine cu greșeli în lanțurile generate. Pentru a mitiga efectele greșelilor, diversitatea demonstrațiilor contează. Această lucrare propune Auto-CoT, care eșantionează întrebări cu diversitate și generează lanțuri de raționament pentru a construi demonstrațiile.

Procesul Auto-CoT

Auto-CoT constă din două etape principale:

- Clustering-ul întrebărilor: Împarte întrebările unui set de date dat în câteva clustere

- Eșantionarea demonstrațiilor: Selectează o întrebare reprezentativă din fiecare cluster și generează lanțul său de raționament folosind Zero-Shot-CoT cu euristici simple

Euristicile simple ar putea fi lungimea întrebărilor (de exemplu, 60 de token-uri) și numărul de pași în raționament (de exemplu, 5 pași de raționament). Aceasta încurajează modelul să folosească demonstrații simple și precise.

Procesul este ilustrat mai jos:

Sursa imaginii: Zhang et al. (2022)

Beneficii cheie

- Raționament complex: Permite gândirea logică în mai mulți pași

- Performanță mai bună: Îmbunătățește rezultatele la sarcinile aritmetice și de raționament

- Capacitatea Zero-shot: Funcționează cu prompturi simple precum "Să gândim pas cu pas"

- Generarea automată: Auto-CoT elimină crearea manuală de exemple

Aplicații

- Rezolvarea problemelor matematice

- Sarcini de raționament logic

- Descompunerea problemelor în mai mulți pași

- Luarea deciziilor complexe

- Aplicații educaționale

Subiecte conexe

- Promptarea cu câteva exemple - Învățarea din exemple

- Promptarea Zero-shot - Promptarea fără exemple

- Ghidul de inginerie a prompturilor - Tehnici generale de inginerie a prompturilor

Referințe

- Wei et al. (2022) - Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

- Kojima et al. (2022) - Large Language Models are Zero-Shot Reasoners

- Zhang et al. (2022) - Automatic Chain of Thought Prompting in Language Models